人工智能自动推理-红米note智能人工语音

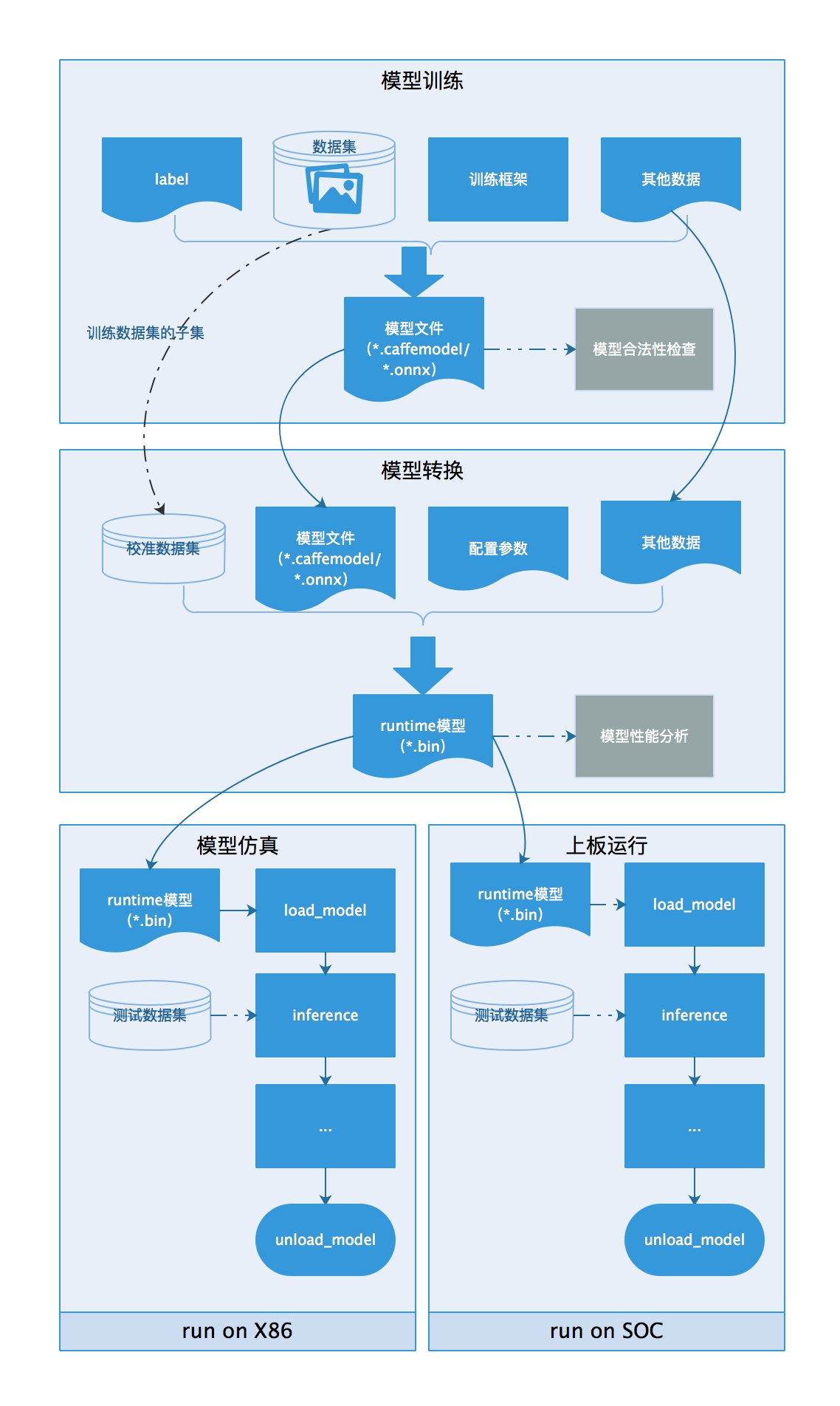

多框架模型统一管理

支持Tensorflow、Pytorch、Caffe、MXnet等主流框架模型,支持ONNX格式模型

支持自定义镜像,通过页面配置快速部署,以及云原生方式进行自定义编排

支持模型导入、查询、删除等操作

支持个人模型、组模型的权限管控

应用服务全周期管理

支持Tensor Serving、Torch Serving、Triton推理引擎

支持离线测试,方便开发人员在模型发布前验证模型准确性

支持A/B测试与滚动发布进行模型迭代升级

支持服务弹性伸缩,根据流量自动调整服务实例数量

提供周期部署与定时部署的服务调度策略,解决不同时段的业务算力需求

支持流量调节、批量处理、业务下线等操作

支持边缘场景下的推理服务部署,状态查看及管理操作

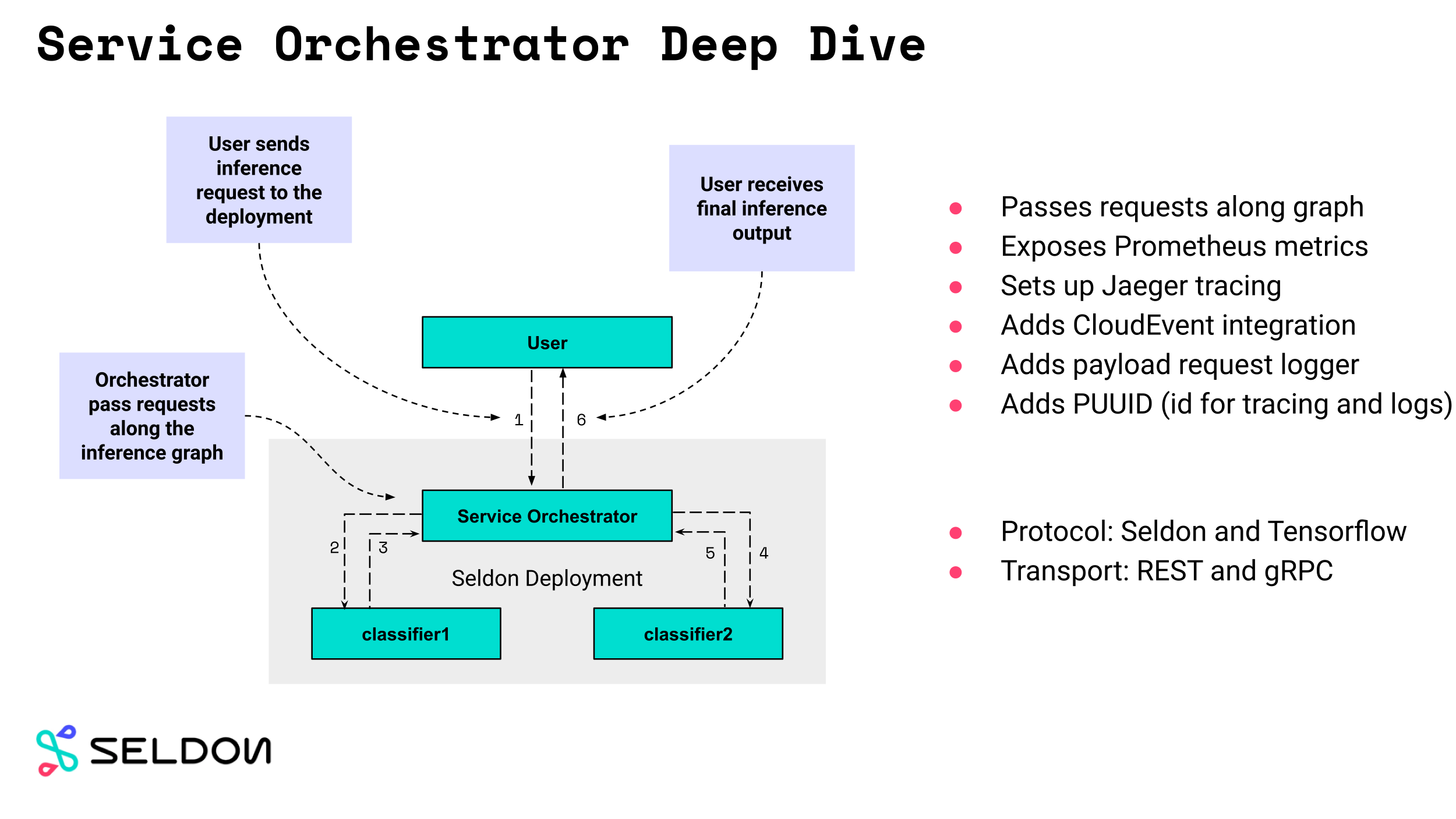

应用请求快速响应

优化网络模型,减少网络代理延迟

深度调优网络参数人工智能自动推理,减少网络延迟

服务延迟1ms,业内领先水平

资源性能监控

简洁直观的集群监控界面,核心参数一目了然

强大的扩展能力,支持用户自定义页面

丰富的日志检索能力,支持检索模版

日志分析能力出众,支持分析结果可视化

产品优势

轻松部署推理服务,提速AI生产交付

提供自动快捷的模型部署方式及服务调用方式,一键实现滚动发布、A/B测试、服务回滚等高级服务部署功能,模型部署上线从2-3天缩短到几分钟;

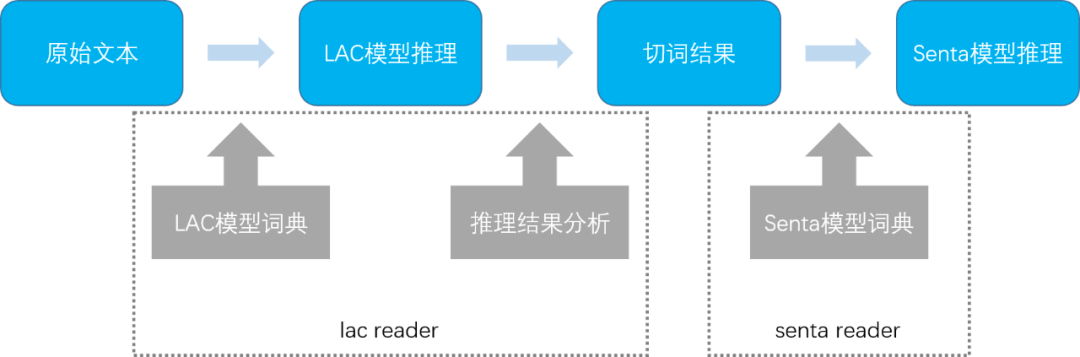

灵活开放人工智能自动推理,ISV应用统一适配

支持TensorFlow、Pytorch等主流深度学习框架,同时兼容用户自定义框架,无缝对接企业自研或外购AI模型,满足企业多样化的应用场景;

计算资源统一管理,敏捷高效调配

支持英伟达、寒武纪、昆仑芯、高通等6家国际国内厂商的12款AI和GPU芯片的多元算力支持,针对不同AI应用的计算特点按需动态调配计算资源,支持GPU单卡算力细粒度切分,集群资源利用率从40% 提高到 80%;

低延迟高吞吐,秒级响应线上业务

高并发高吞吐,服务响应平均延迟低于1ms;服务资源弹性扩缩,应对突发场景可在几分钟内自动完成服务扩容,提升整体性能;

智能容错,保障业务平稳运行

支持平台服务的健康监控及容错,自动感知服务资源异常情况,并为线上服务选取可用计算资源进行主动迁移。

上一篇

上一篇