python 爬取整个网站-python 爬取知乎用户

都说python爬取网页数据方便python 爬取整个网站,今天就来试试,python爬取数据有多方便

介绍

爬取数据基本是通过网页的URL获取网页的源代码,根据源代码筛选出需要的信息

准备

集成开发环境:pyCharm

图书馆:请求,lxml

下面简单介绍一下这两个库主要为我们服务的是什么。

requests:获取网页源码

lxml:获取网页源码中的指定数据

简洁吗?^_^

搭建环境

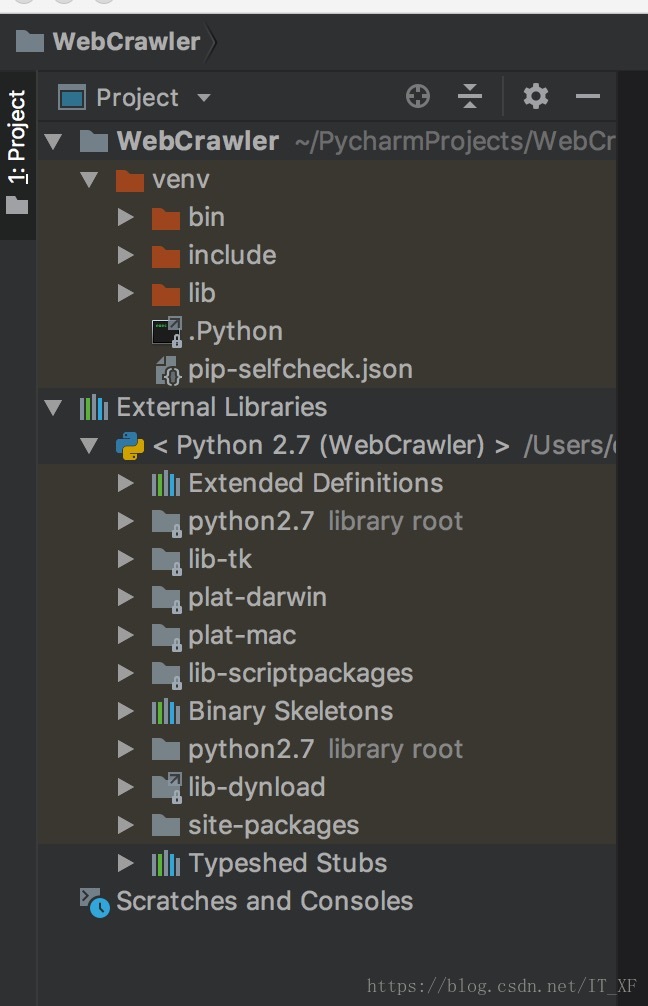

这里的搭建环境不是搭建python开发环境。 这里的搭建环境是指我们使用pycharm创建一个python项目,然后进行requests和lxml

创建一个新项目:

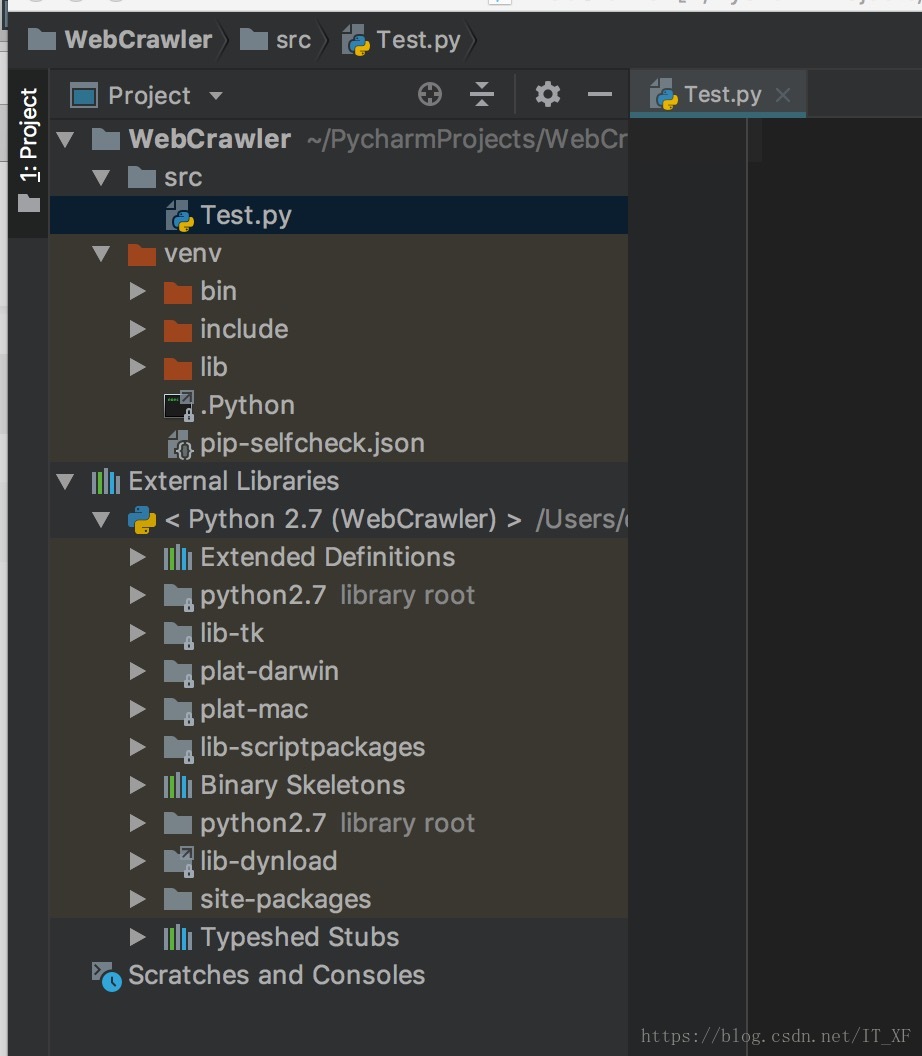

没有什么裸的,新建一个src文件夹,直接在里面新建一个Test.py

依赖库导入

我们不是说要使用请求吗,来吧

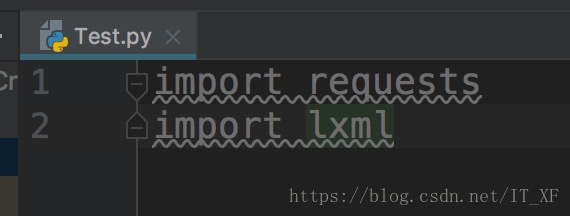

由于我们使用的是pycharm,所以我们导入这两个库会非常简单,如图:

在Test.py中输入:

import requests这时候requests会报红线。 这时候我们把光标对准requests,按下快捷键:alt+enter,pycharm就会给出解决方案。 这个时候选择install package requests,pycharm会自动帮我们安装好。 ,我们只需要稍等片刻即可安装库。 lxml的安装方法同上。

安装这两个库后,编译器不会报红线

接下来进入快乐的爬虫时间

获取网页源代码

前面说过,requests可以很方便的让我们拿到网页的源码

网页以我的博客地址为例:

获取源代码:

# 获取源码

html = requests.get("https://blog.csdn.net/it_xf?viewmode=contents")

# 打印源码

print html.text代码就是这么简单,这个html.text就是这个网址的源码

获取指定数据

现在我们已经拿到了网页的源码,接下来我们需要使用lxml过滤出我们需要的信息

这里我以获取我的博客列表为例

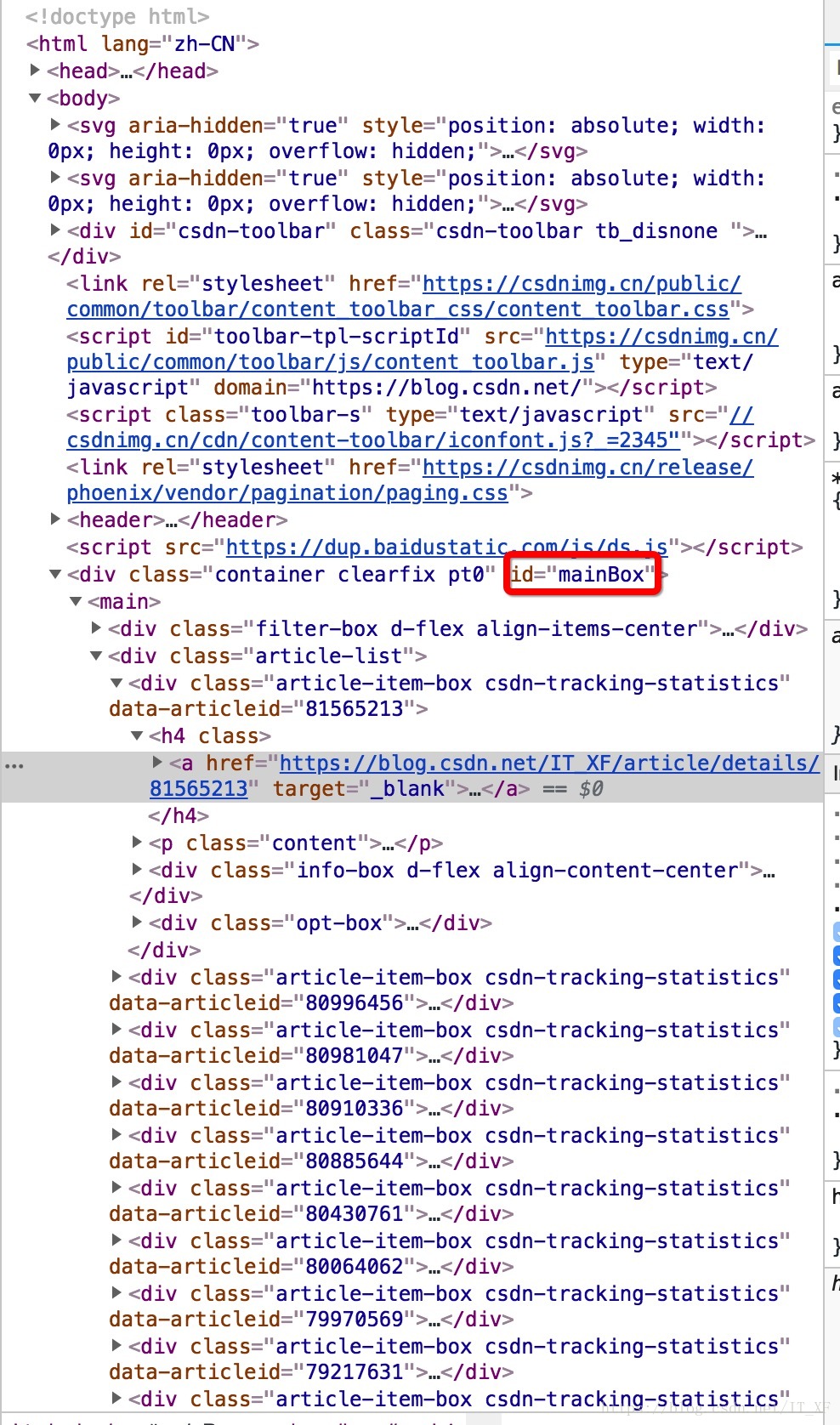

首先,我们需要分析源码。 我这里用的是chrome浏览器,所以右键查看,是这样的画面:

然后在源码中,定位找到第一篇文章

像这样?

操作太快看不清楚是吧?

这里说明一下,先点击源代码页右上角的箭头,然后在网页内容中选择文章标题。 此时,源代码将位于此处。

此时选中源代码的title元素,右键复制,如图:

搞定xpath,咦,你知道这是什么吗,这个东西相当于一个地址。比如源码中网页上长图片的位置,我们不是复制过来的,粘贴出来看看是什么看起来像

//*[@id="mainBox"]/main/div[2]/div[1]/h4/a这是给你的解释:

// 定位根节点

/ 往下层寻找

提取文本内容:/text()

提取属性内容:/@xxxx这个表情后面两个我们还没见过,以后再说,先放个图

表达式://*[@id="mainBox"]/main/div[2]/div[1]/h4/a

我们想一下,首先,//表示根节点,也就是说,如果这个//后面的东西是根,就说明只有一个

也就是说,我们需要的,在里面

那么/就是寻找下层的意思。 根据图片也很明显,div -> main -> div[2] -> div[1] -> h4 -> a

跟踪到a这里,我想你应该明白了,然后我们在末尾添加/text表示我们要提取元素的内容,所以我们最终的表达式是这样的:

//*[@id="mainBox"]/main/div[2]/div[1]/h4/a/text()这个表达只是针对这个网页的这个元素,不难理解吗?

那么这个东西怎么用呢?

所有代码:

import requests

from lxml import etree

html = requests.get("https://blog.csdn.net/it_xf?viewmode=contents")

# print html.text

etree_html = etree.HTML(html.text)

content = etree_html.xpath('//*[@id="mainBox"]/main/div[2]/div[1]/h4/a/text()')

for each in content:

print(each)此时each中的数据就是我们要获取的数据

打印结果:

如何撸一个ArrayList

打印结果就是这个结果,我们去掉换行和空格

import requests

from lxml import etree

html = requests.get("https://blog.csdn.net/it_xf?viewmode=contents")

# print html.text

etree_html = etree.HTML(html.text)

content = etree_html.xpath('//*[@id="mainBox"]/main/div[2]/div[1]/h4/a/text()')

for each in content:

replace = each.replace('\n', '').replace(' ', '')

if replace == '\n' or replace == '':

continue

else:

print(replace)

打印结果:

如何撸一个ArrayList 非常好,如果我们想获得所有博客的列表怎么办

看图看表情分析方法

表达式://*[@id="mainBox"]/main/div[2]/div[1]/h4/a/text()

其实我们不难发现,main->div[2]其实包含了所有的文章,只是我们取了main->div[2]->div[1],也就是说我们只取了第一篇。所以python 爬取整个网站,其实表达式这样写,就可以得到所有的文章

//*[@id="mainBox"]/main/div[2]/div/h4/a/text()再次:

import requests

from lxml import etree

html = requests.get("https://blog.csdn.net/it_xf?viewmode=contents")

# print html.text

etree_html = etree.HTML(html.text)

content = etree_html.xpath('//*[@id="mainBox"]/main/div[2]/div/h4/a/text()')

for each in content:

replace = each.replace('\n', '').replace(' ', '')

if replace == '\n' or replace == '':

continue

else:

print(replace)

打印结果:

如何撸一个ArrayList

Android相机屏幕适配

Tinker关于clean后准基包消失的解决方案

Tinker使用指南

git分支的使用

如何将Androidstudio中的项目导入到第三方的git托管库中

遍历矩阵

从矩阵中取出子矩阵

AndroidStudio配置OpenCV

一步一步了解handler机制

Android常用框架

Android绘制波浪线

RxJava系列教程之线程篇(五)

RxJava系列教程之过滤篇(四)

RxJava系列教程之变换篇(三)

RxJava系列教程之创建篇(二)

RxJava系列教程之介绍篇(一)

一个例子让你彻底理解java接口回调

SharedPreferences的用法及指南

异步加载网络图片带进度

VideoView加载闪黑屏

android视频播放vitamio的简单运用

仿网易新闻分类刷新

ListView加CheckBox简单实现批量删除

Android如何高效加载大图

Android聊天界面实现方式

抽屉侧滑菜单Drawerlayout-基本使用方法

android-引导页的实现方式

Java设计模式--工厂模式的自述

javaweb学习路线

getWindow().setFlags()使用说明书

歪解Activity生命周期-----初学者彻底理解指南很好,我们得到了所有文章的列表。

总结

我们使用requests获取网页列表,使用lxml过滤数据。 我们可以看到python在网页上爬取数据真的很方便。 Chrome也支持直接在源码中获取表达式xpath。 这两个库的内容肯定不止这一点,还有很多功能等着你去挖掘。 顺便说一句,在写这篇博客的过程中,我发现了一个很重要的问题:我写的文章太少了! 【逃脱】

上一篇

上一篇