人工智能计算器2.1-人工智能巨量模型“源1.0”重兵加速行业洗牌

“战鼓催征千嶂寒,阴阳交会九皋盘。飞军万里浮云外,铁骑丛中明月边。”

猜猜这首诗的作者是谁?李白?王昌龄?岑参 ?李贺?

其实这首诗是全球最大规模中文人工智能巨量模型 “源1.0”基于强大的自然语言处理能力,即兴创作的诗歌。

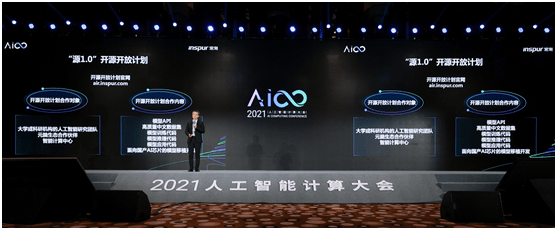

近日,在人工智能计算大会(AICC)2021上,全球最大规模中文人工智能巨量模型 “源1.0”首次亮相,并通过与观众实时互动的方式展现全球顶尖中文巨量模型的智慧魅力。

与此同时,浪潮对外公布了 “源1.0”开放开源计划,“源1.0”将面向学术研究单位和产业实践用户进行开源、开放、共享,降低巨量模型研究和应用的门槛,打造新型算法基础设施建设。

“人工智能如何发展出像人类具备逻辑、意识和推理的认知能力,是人工智能研究一直在探索的方向。目前来看,通过大规模数据训练超大参数量的巨量模型,被认为是非常有希望实现通用人工智能的一个重要方向。”中国工程院院士、浪潮首席科学家王恩东院士在AICC2021上表示,随着巨量模型的兴起,巨量化已成为未来人工智能发展非常重要的一个趋势。

“源1.0”的领先性

目前,全球知名的AI领先公司在巨量模型上都予以重兵投入,谷歌、微软、英伟达、浪潮、智源研究院、百度、阿里等公司相继推出了各自的巨量模型。

浪潮信息副总裁、浪潮信息AI&HPC产品线总经理刘军表示,进入到巨量模型时代,人工智能产业的发展得益于产业界的通力合作。“浪潮通过元脑生态把AI科技公司(左手伙伴)和行业客户(右手伙伴)连接到一起,赋能产业创新。而‘源1.0’的推出将加速这一进程。”

衡量巨量模型(也称单体模型)最重要的三个层面是算法、数据及精度,而“源1.0”巨量模型在三个方面都做到全球领先。

算法:“源1.0”训练采用的中文数据集达5000GB,相比美国OpenAI组织研发的GPT-3模型1750亿参数量和570GB训练数据集,源1.0参数规模领先40%,训练数据集规模领先近10倍,问鼎全球最大规模中文AI巨量模型。

数据:爬取2017-2021近五年来,中文互联网中的网页数据、公开中文语料库、中文百科及电子书等,经过清洗及处理,最终获得5000GB高质量数据集,是GPT-3的近10倍,成为迄今业界最大的高质量中文数据集。

精度:“源1.0”在语言智能方面表现优异,获得权威中文语言理解评测基准CLUE榜单的零样本学习和小样本学习两类总榜冠军。在零样本学习榜单中,“源1.0”超越业界最佳成绩18.3%,在文献分类、新闻分类,商品分类、原生中文推理、成语阅读理解填空、名词代词关系6项任务中获得冠军;在小样本学习的文献分类、商品分类、文献摘要识别、名词代词关系等4项任务获得冠军。在成语阅读理解填空项目中,源1.0的表现已超越人类得分。

同时,在对“源1.0”进行的“图灵测试”中,将“源1.0”模型生成的对话、小说续写、新闻、诗歌、对联与由人类创作的同类作品进行混合并由人群进行分辨,测试结果表明,人群能够准确分辨人与“源1.0”作品差别的成功率已低于50%。

浪潮人工智能研究院首席研究员吴韶华表示人工智能计算器2.1,“源1.0”只是一个开端,未来还会有2.0、3.0等,目前“源2.0”的相关工作正在进行讨论中。而且2.0会更加重视与顶尖科技公司的联合探索,贴近应用场景,能够更快速实现应用落地,这种聚合效应有助于前沿技术的探索,也会带来更多的创新成果。

专注于自然语言处理,面向多场景AI任务

开头我们看到的诗歌创作只是“源1.0”的小试牛刀,“源1.0”专注于自然语言处理领域,可以创建任何具有语言结构的东西,自动问答,撰写论文、文章、诗歌、小说、新闻报道,提炼总结长文本,翻译语言,甚至可以创建计算机代码。最为重要的是,源1.0大模型可以产生创作“灵感”,可以理解文字背后的含义,并从文本中抽取关键信息,如从智能客服对话中感知客户情绪,以便更智能的满足客户需求,提供更优质服务。

“源1.0”大模型将应用于杀手级的应用场景,比如运营商的智能运维,在智能办公场景自动生成报告,在手机互联网场景自动对话的智能助手,在电商互联网场景中的智能客服,及文字识别、文本搜索、翻译等应用场景。

吴韶华表示,以GPT-3为代表的巨量模型显了小样本学习以及泛化能力,可以支撑各种任务和应用场景。“当前的源1.0聚焦在自然语言理解领域,后续我们将开展图像、多模态领域巨量模型的探索。我们的目标是从专用智能走向通用智能。”

其实通过开源计划,“源1.0”可以帮助业界探索前沿的技术,推动智能产业发展。据悉,“源1.0”从数据、API、代码这些方面进行开源开放,将开源最先进的研究成果、最核心的代码和社区连接到一起。同时,浪潮会和合作伙伴一起推动“源”在国产芯片的应用迁移和开发。

“生态化是计算产业发展的重要趋势,没有生态的繁荣,也就没有产业的繁荣。开放、丰富、百花齐放,对于我们现在来说非常重要。”刘军说。

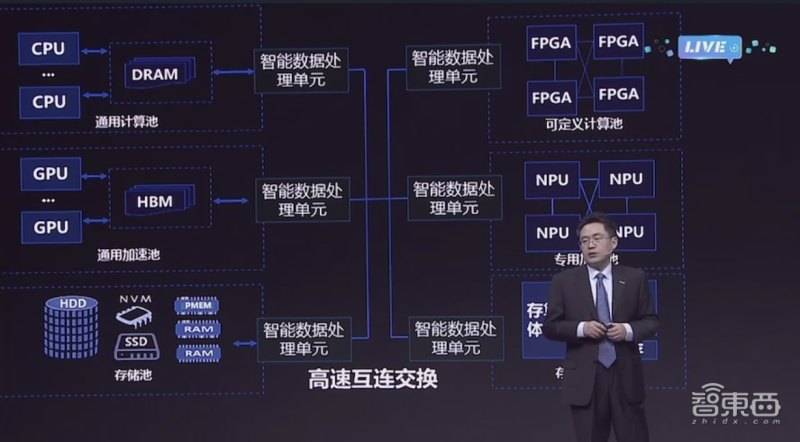

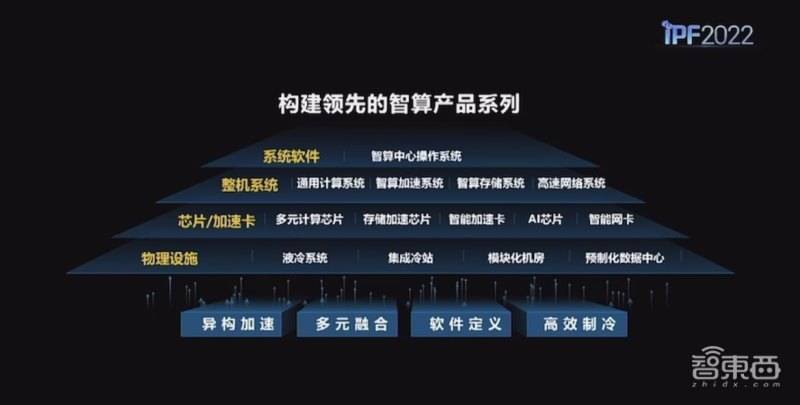

算法算力协同优化创新

巨量模型训练本身是一个技术门槛特别高的研究工作,因为它不仅需要在大规模集群上进行训练,同时要求发挥大规模集群最好的性能。因此需要在模型分布式计算等各个层面上进行协同方面的一些设计、优化。

算法:解决了巨量模型训练不稳定的业界难题,提出了稳定训练巨量模型的算法,训练出2457亿参数的全球最大AI巨量模型;巨量模型推理方法创新,提升模型的泛化能力,让一个模型更好的服务不同应用。

数据:创新中文数据集生成方法,研制高质量文本分类模型,收集并清洗互联网文本数据,有效过滤垃圾文本,生成5000GB高质量数据集,是迄今业界最大的高质量中文数据集。

算力:算法算力协同优化,优化巨量模型结构,使模型更利于AI算力的性能发挥,实现计算效率大幅提升,在同比算力提升12%的情况下,参数集规模提升40%,达到业界第一训练性能的同时实现业界领先的精度。

刘军表示,巨量模型是一个复杂的系统工程。要做好巨量模型,实际要求算力、算法、数据三架马车协同创新。浪潮非常擅长把算力、算法、数据进行整合,“源1.0”在这三方面进行了积极探索。

浪潮一直活跃在AI前沿方向,在异构加速计算、深度学习框架、AI算法等领域取得了一定的成绩。目前人工智能计算器2.1,浪潮的AI服务器市占率已位居全球第一,连续四年中国市场占比超过50%;在深度学习框架领域,浪潮先后推出了深度学习并行计算框架Caffe-MPI、TensorFlow-Opt、全球首个FPGA高效AI计算开源框架TF2等等。

同时,浪潮在全球顶级的AI赛事上也不断取得好成绩,累计获得56个MLPerf全球AI基准测试冠军,近几年浪潮在CVPR、NIPS、GAIIC等国际大会大赛中,在多模态视觉问答、大场景多对象检测以及自动机器学习等领域都取得了非常不错的表现。

此外,浪潮连续三届担任国际基准评测组织SPEL ML技术委员会主席,推动国际开放AI基准评测的建立。2020年,浪潮在人工智能领域的专利贡献达到1174件,位居中国前列。

所以说,全球最大的中文AI巨量模型诞生,得益于浪潮在人工智能领域深厚的积累和不断的探索实践。刘军表示,持续创新是浪潮的本色,在产业层面,浪潮满足客户、市场和应用需求;在科研创新方面,浪潮探索科学前沿。

上一篇

上一篇