人工智能 训练 推理-智能投顾人工投顾

人工智能研究包括推理应用、机器人、语言识别、图像识别、自然语言处理等。进入21世纪以来,随着新一代信息技术的高速发展,全球科技创新进入空前的活跃时期,在人工智能、量子信息、移动通信、物联网、区块链为代表的创新技术下人工智能 训练 推理,不断加速对行业应用的实际落地。人工智能,是这新一轮科技革命和产业变革的重要驱动力量。

OpenVINO是桥接深度学习与前端推演的快速赋能平台

基于AI Box的OpenVINO工具套件支持TensorFlow、PyTorch、PaddlePaddle等多个深度学习框架,并且可以很方便地部署在英特尔的CPU、iGPU、VPU、FPGA等多个硬件平台上,同时可以兼容Windows、 Linux,以及macOS。

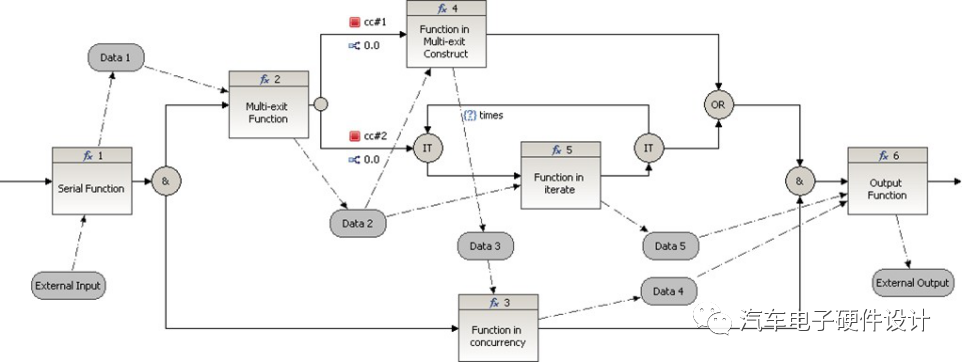

AI BOX OpenVINO架构图解

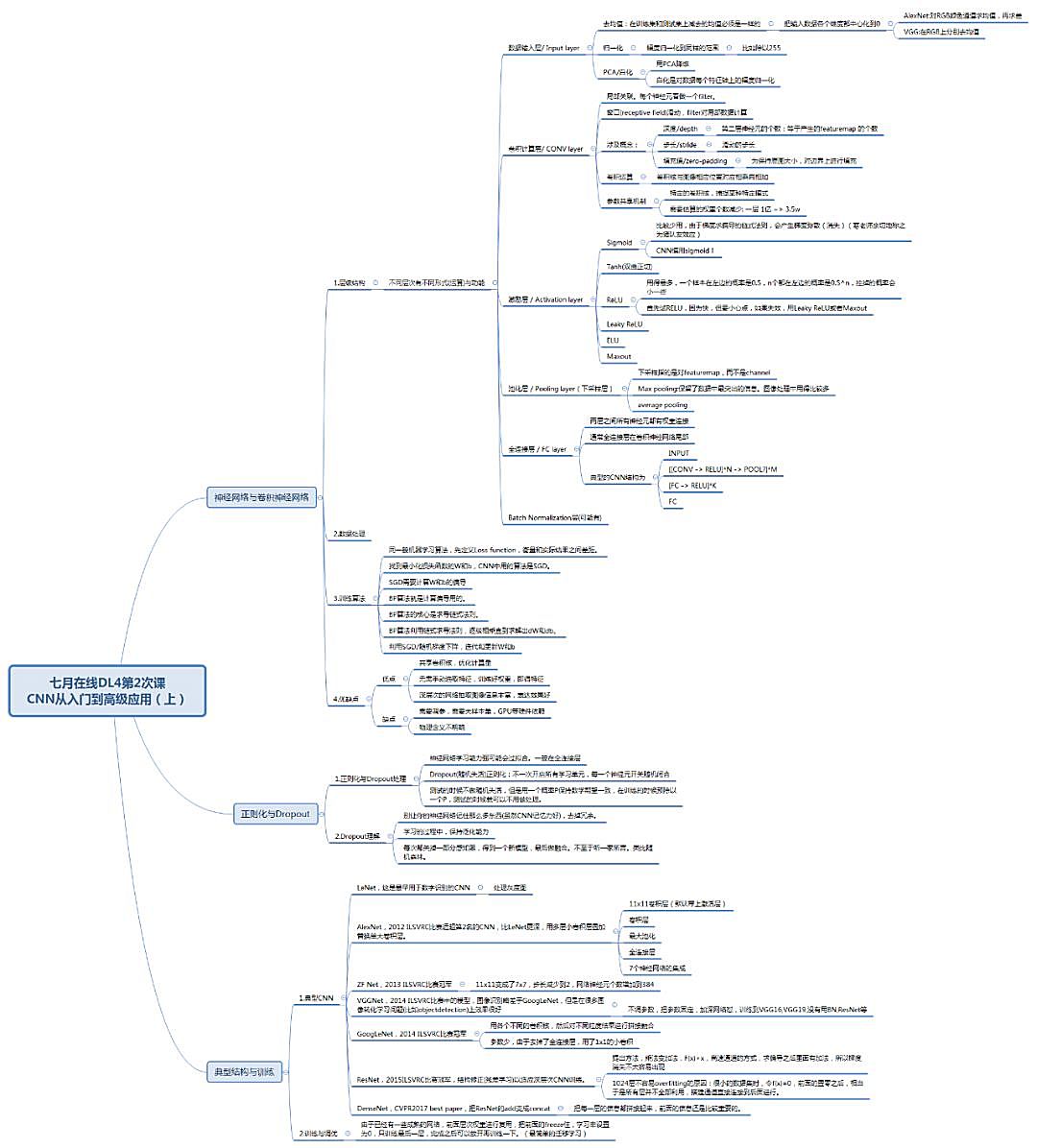

深度学习框架

深度学习框架简单理解就是一个库,在我们需要使用的时候只需要去调用函数即可,如:import caffe、import tensorflow。例如,我们使用积木去搭建符合自己的数据集,那么一整套深度学习框架的各个组件就是其中的某一个算法或者模型。

目前常用的学习框架:TensorFlow、飞桨、PyTorch、Caffe、ONNX、mxnet、Keras等。

每一种深度学习框架都具备优缺点,在选择的时候需要依据自身项目需求为准,比如对图像卷积处理,就会使用Caffe、MXNet;TensorFlow既支持机器学习算法还支持增强学习算法。

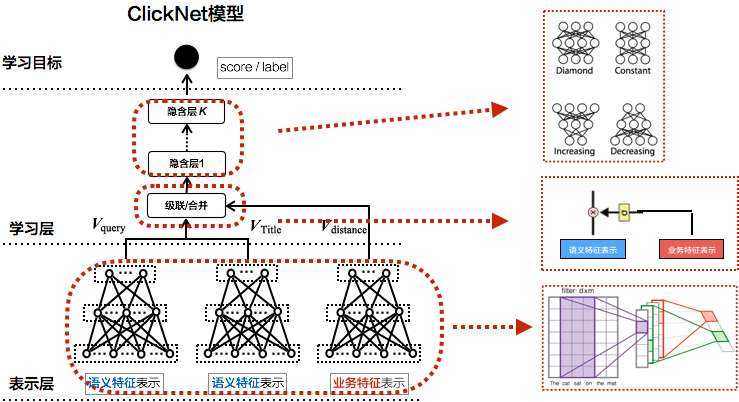

OpenVINO模型推理

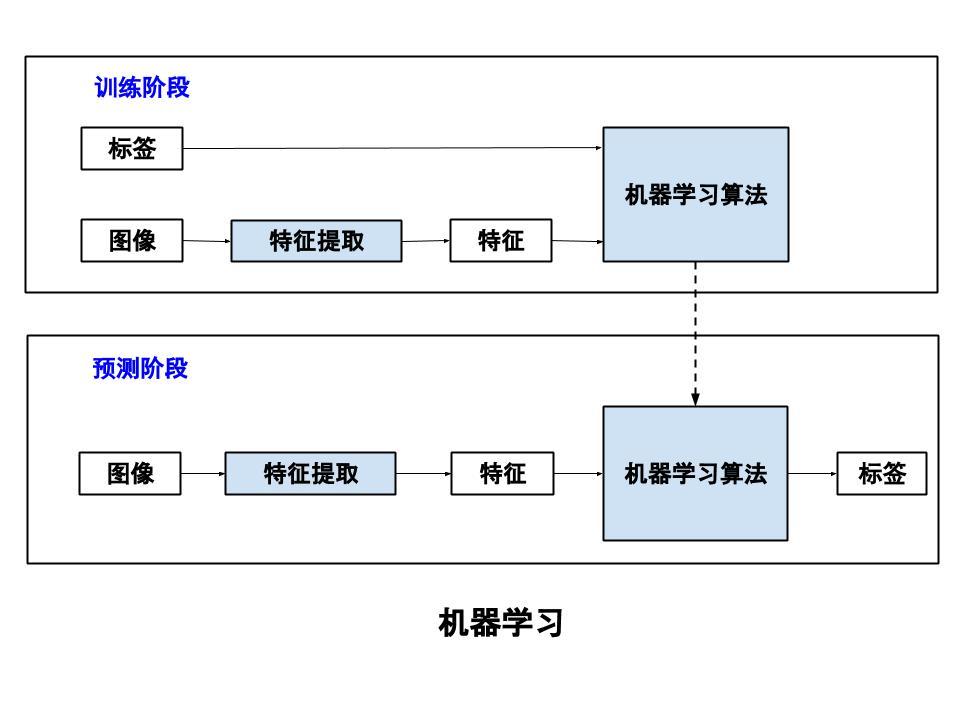

AI边缘人工智能的实施大致可分为两个阶段,首要的是训练,从数据集的采集、模型的训练、参数的调试,来找到一个适合的模型;第二阶段就是部署,将模型移植到不同设备进行推理计算。

在这里,我们推荐使用英特尔的OpenVINO ToolKit工具,加速推理达到边缘人工智能应用的最佳性能(速度、精度)。

首先利用Caffe、TensorFlow等工具进行创建和训练CNN推理模型;之后通过Model Optimizer模型优化器运行模型,生成用于Inference Engine中的IR文件,存储文件包括(.bin文件和.xml文件);最后我们使用应用程序调用推理引擎和IR文件,以在目标设备上加载和运行模型。

OpenVINO模型推理过程

OpenVINO模型推理过程

01、训练(Train):通过代码和大数据进行训练模型。

02、模型优化器(Model Optimizer):训练好的模型将被送到Model Optimizer ,在进一步优化训练模型的同时,生成训练模型的中间文件,也就是IR文件(.xml+.bin)。在此过程中,根据所选框架配置预训练模型,通过量化、冻结、融合等技术对模型进行优化。

03、推理引擎(Inference Engine):IR文件被馈送到推理引擎。推理引擎的工作是根据用于训练模型的框架以及使用的硬件(也称为环境)检查模型兼容性。

04、部署(Deployment):将应用程序部署到设备上。

基于AI Box的OpenVINO工具套件使代码易于采用维护。其中,Open Model Zoo已经提供了经过压缩、优化之后的预训练模型,而Model Optimizer API参数也能够使得转换模型的工作变得更便捷。运行推理引擎同样可使用户在特定设备进行编译优化网络和管理推理运算人工智能 训练 推理,进而调整算法性能,并可通过跨CPU、GPU等设备的并行推理来进行自动优化。

OpenVINO工作全流程

AI BOX + OpenVINO 产品优势

应用实例

上一篇

上一篇