人工智能逻辑-asc智能逻辑控制系统

随着这一轮人工智能的发展热潮,社会上普遍存在担忧和质疑:机器会不会取代人类,人工智能会不会成为人类文明史的终结?

在未来的人类生活中,人工智能也将发挥越来越重要的作用。 对于这样的画面,我们不必恐慌,但也不能忽视。 监管人工智能,找准方向,采取合理措施,正是当下应该关注的政策问题。

人工智能在其跌宕起伏的60年历史中再次迎来了高潮。 但伴随着这一轮发展高潮,社会上也普遍存在着担忧和质疑:机器会不会取代人类,人工智能会不会成为人类文明史的终结?

这样的担忧有其道理,也正是基于此,政府干预和规范人工智能发展的呼声层出不穷。 但问题是:如何规制一个尚未成为现实、只存在于想象中的“威胁”,以防止“孩子被洗脚水泼出去”?

事实上,监管的挑战不在于如何平衡技术发展的利弊,而在于如何准确定位技术的潜在威胁并实施针对性监管。 换句话说,人工智能真的有“取代人类”的危险吗? 如果是这样,唯一合理的监管方式可能就是完全禁止这项技术的发展。 考虑到人工智能技术的应用已经渗透到生活的方方面面,从搜索引擎到社交网络再到定制新闻。 也正是因为如此,我们或许需要重新思考当前对人工智能的担忧是否有道理。 如果不是,它真正的威胁是什么? 只有回答这些问题,才能找到规范人工智能的合理路径,使其更有效地服务于人类和未来。

人工智能:担心什么

2016年10月19日,霍金在剑桥大学莱弗休姆未来智能中心开幕式上发表演讲,声称“人工智能可能是人类文明史的终结……在人类历史上,它可能是最好的,也可能是最差的”。 这不是霍金第一次警告人工智能的发展。 在2014年接受BBC采访时,他也表达了类似的观点。 此后,霍金还积极参与宣传和推动人工智能研究的合理规范。 事实上,莱弗休姆未来智能中心成立的重要使命之一就是化解AI(人工智能)可能带来的风险。

霍金并不是唯一一个“令人担忧”的人。 特斯拉和SpaceX的创始人埃隆马斯克也多次警告人工智能隐藏的巨大风险。 在霍金、马斯克等人的推动下,超过892名人工智能研究人员和另外1445名专家共同签署并发布了《人工智能23条原则》,确保人工智能发展走上正轨。

人工智能是否会取代甚至“奴役”人类的可能性,并不是人们关心的唯一问题。 人工智能对就业的冲击和社会不平等的加剧也是人们焦虑的重要原因。 《未来简史》作者尤瓦尔·赫拉里直接指出,人工智能的发展将导致大规模失业等社会问题的出现,并使少数人成为“新精英”。超人”,而大多数人类将沦为经济政治意义上一文不值的个体,人类将进入最不平等的时代。

我们应该相信霍金、马斯克和哈拉里对人工智能的担忧吗? 不同的人有不同的看法。 扎克伯格曾经批评过马斯克。 他认为,“对人工智能安全性的担忧,就像担心如果飞机在200年前坠毁了怎么办。如果我们总是过于担心安全性,我们将无法制造出飞行器。” 事实上,历史上任何颠覆性的技术进步都伴随着诸多质疑,无论是原子能技术的发明,还是基因工程的突破。但历史最终证明,人类社会的发展并没有陷入混乱或终结,这也表明,当前对人工智能的担忧可能有些夸大。

但另一方面,人工智能的发展确实存在巨大的潜在风险,放任自流的监管态度显然不是最佳选择。 还需要指出的是,自1960年代经合组织提出“知识社会”概念以来,科技发展已成为土地与人口并重的国家竞争力的重要体现之一。 如何通过合理监管有效引导国家人工智能技术发展,自然成为各国政府无法回避的难题。 正因如此,当前争论的核心不是“人工智能的发展要不要监管”,真正的挑战在于“监管什么”和“怎么监管”。

其实,只有回归到人工智能技术本身,从它的基本原理出发,才能正确认识人工智能是什么,它能做什么,不能做什么,隐藏的价值和风险是什么。 只有在正确认识这些问题的基础上,才能对未来的监管政策提出有益的建议。

算法背后的基石:数据和规则

经历了2016年的火热,很多人已经可以感知到人工智能的无处不在,以及支撑其运行的机器学习算法。 无处不在的人工智能已经开始逐渐影响我们的日常生活。 计算设备在“吞噬”海量数据的同时,神奇地产生与你相关的各种信息、产品和服务。

但是这个过程是如何发生的呢? 基于机器学习算法的人工智能是否会不断完善并最终超越人类控制? 要回答这个问题,还得回到机器学习的算法本身来。

算法本质上是一系列指令,告诉计算机该做什么。 对于传统算法,机器在给定条件下的预定动作往往是详细指定的; 机器学习算法利用对现有数据的“学习”,使机器能够在不同于历史数据的新情况下执行。 法官。

具体来说,机器学习算法可以有多种实现方式,但就目前的技术发展来看,主要可以分为符号学派、联系学派、进化学派、类比学派和贝叶斯学派五类。 每个流派遵循不同的逻辑,以不同的思路实现机器学习的过程。

对于“符号学派”来说,所有的信息处理都可以简化为对符号的操作,因此学习过程被简化(抽象)为一个基于数据和假设的规则归纳过程。 符号学派在数据(即当前事实)和已有知识(即预设条件)的基础上,通过“提出一个假设——数据验证——进一步提出新的假设——”的过程来训练机器的学习能力。引入新规则”。 从而实现新环境下的决策和判断。 符号学派虽然符合经验主义的哲学认知,但通过其概念模型我们也可以发现,其成功的关键在于数据的完整性和人为预设条件的可靠性。 也就是说,数据的缺乏和预设条件的不合理都会直接影响机器学习的输出(即决策规则的归纳)。 这个问题最明显的例子就是罗素的“归纳火鸡”:经过10天的观察(数据集不完整),火鸡得出结论(代表预设条件不合理,10多个确认数据是接受规则),主人会在每天早上9:00给它喂食; 但后来是平安夜早餐,主人不喂它而是杀了它。

数据和前提的问题不仅存在于符号学派,对其他学派也很普遍。 “连接学派”试图模拟人脑的学习过程,通过模拟神经元的连接结构,并借助反向传播算法自动调整每个连接的权重(反馈输出和输入的比较,根据参数调整on error),达到最终的学习能力。 这里的关键仍然是输入数据集的完整性,以及预设条件(如停止反馈调节的阈值设置)的可靠性。 “进化学派”试图模拟人类的进化过程。 在预先设定的适应度目标(例如在垃圾邮件过滤算法的设计中,将某条规则正确分类邮件的百分比作为适应度目标)的指导下,通过交叉和不同的实验。 规则集找出对测试数据适应度最高(即形成学习能力)的规则集。 由此还是可以看出数据和预设条件(健身目标的设定)的重要性。 “类比学派”也是如此,其基本思想是通过判断不同场景的相似性,推导出新场景下的合理决策。 在这方面,参考数据集的完整性和不同场景相似度的阈值设置(预设条件)仍然是影响机器学习结果的关键点。 与前四种思想相比,贝叶斯学派对数据集的规模没有太高的要求,因为它的优势在于对未来不确定性的学习和探索。 贝叶斯算法将根据收到的新数据不断测试已成立假设的概率,并实时调整它们。 但即便如此,贝叶斯算法仍然受制于输入数据和调整规则。 也就是说,数据和人为预设的条件仍然是控制贝叶斯算法的关键。

事实上,如果跳出特定学派的思维束缚,每一种机器学习算法都可以归纳为“表示方法、评价和优化”三部分。 虽然机器可以通过不断优化自身来提高学习能力,原则上什么都能学,但是用于评价的数据、评价的方法和原则都是由人决定的。 也正是从这个角度来看,本文开头提到的“机器代替人类”的可能性实际上为零——尽管机器可能变得复杂到人类无法理解它们。

监管人工智能:真正的挑战是什么

正如霍金、马斯克等人倡导的“人工智能23条原理”一样,人工智能的发展确实需要走上正轨——尽管原因不在于轰动一时的“机器换人论”。

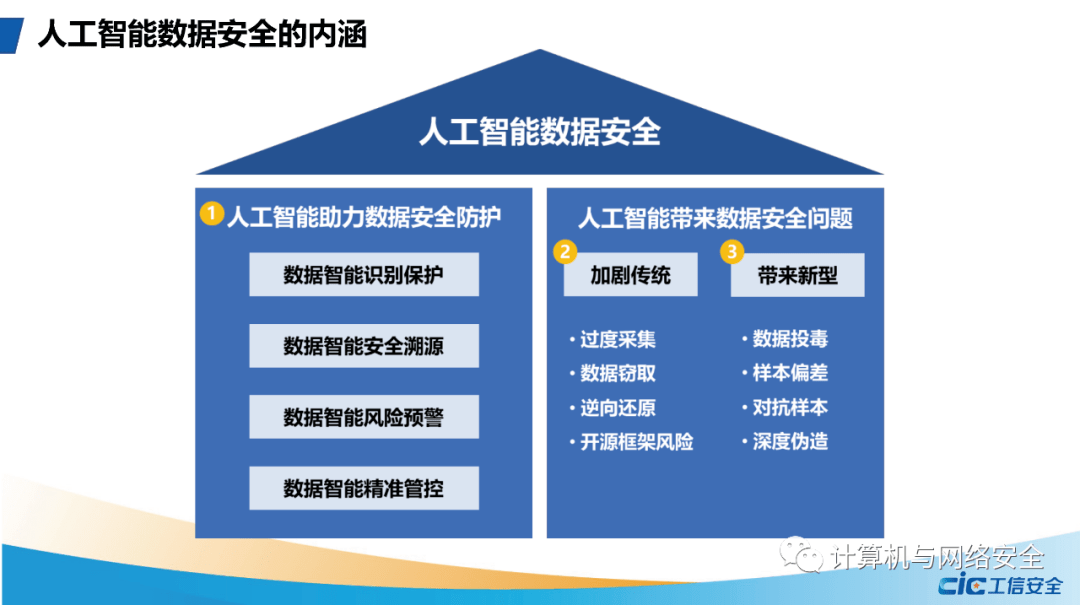

那么应该“监管”什么、“怎么监管”呢? 问题的答案或许在于本文第二部分对机器学习算法的概念描述:既然数据和预设规则是所有算法的基石,那么数据治理和规则治理自然成为监管人工智能的关键。

一方面,我们给机器什么样的数据,机器就会形成什么样的学习能力然后给我们相应的学习结果。 这个过程首先要解决的问题是数据从哪里来,机器将如何使用这些数据? 正如上面反复提到的,不完整的数据集将不可避免地导致人工智能学习过程中的错误——就像罗素的“归纳火鸡”一样。 然而,大规模的数据采集必然带来隐私保护、利益分配等诸多问题。 由此产生的数据治理监管要求,成为人工智能监管的第一步。 在保护个人数据权益的基础上,鼓励和规范数据的共享和应用,最终推动人工智能向更好的方向发展。

另一方面,机器优化的规则(条件)是由谁以及通过什么程序制定的。 尽管我们认为无需对人工智能的发展过度担忧,但真正的威胁依然存在。 事实上,人工智能正以潜移默化的方式影响着人类的日常生活。 如果机器优化的规则没有受到适当程序的监督和约束人工智能逻辑,就很难保证它们不被不法分子利用。 正如长期以来人们对 Facebook 的质疑:公众如何相信它向用户推荐的新闻内容不会被特殊利益集团掺假? 随着越来越多的人依赖定制的新闻推送,人工智能甚至可能影响总统选举。 也正是因为如此,包括透明度和开源在内的诸多治理原则,理应成为人工智能监管政策制定过程中纳入的合理议题。

经过60多年的发展,人工智能终于在互联网、大数据、机器学习等多项技术取得突破的基础上腾飞。 在未来的人类生活中,人工智能也将发挥越来越重要的作用。 对于这样的画面,我们不必恐慌人工智能逻辑,但也不能忽视。 监管人工智能,找准方向,采取合理措施,正是当下应该关注的政策问题。

关注学习时代微信公众号

微信专页

通讯录→公众号→右上角“+”→搜索“studytimes”

文章页面

点击右上角→查看公众号→添加关注

上一篇

上一篇